Robots.txt काम कैसे करता है?

जैसा कि अभी थोड़ी देर पहले मैंने बताया था कि robots.txt को हम अपने ब्लॉग का बॉडीगार्ड या सिक्योरिटी गार्ड कह सकते हैं। तू इस तरह से यह हमारे साइट की privacy की security करता है।

Read More

Robots.txt File के फायदे?

हमें अपने ब्लॉग में robots.txt file जरूर ऐड करना चाहिए। यह हमारे साइट के लिए बहुत जरूरी है। इससे हमारा ब्लॉग SEO फ्रेंडली होता है। और इसे अपने ब्लॉग में लगाने के बहुत से फायदे भी है।

1) robots.txt के मदद से आप अपने ब्लॉग के किसी भी कंटेंट को सर्च इंजन से प्राइवेट रख सकते हैं।

2) इसके इस्तेमाल से आप अपने “sensitive information” को भी प्राइवेट रख सकते हैं।

3) robots.txt के जरिए आप Google bots की मदद भी कर सकते हैं। ब्लॉग के कंटेंट को रैंक (rank) / index करने के लिए।

4) Robots.txt के मदद से सर्च इंजन को यह आसानी से पता चल जाता है कि आपके ब्लॉग की sitemap कहां स्थित है।

5) इसके जरिए आप अपने ब्लॉग के categories, labels, tags, images, document, etc. को सर्च इंजन में rank/index होने से रोक सकते हैं।

6) इसके जरिए आप अपने ब्लॉग के जिस कंटेंट को चाहे, सर्च इंजन मैं इंडेक्स करा सकते हैं। और जिस कंटेंट को चाहे सर्च इंजन की नजरों से दूर रख सकते हैं।

Robots.txt कैसे बनाएं?

वैसे तो robots.txt file generator के नाम से बहुत सी वेबसाइट इंटरनेट पर available है। जो आपकी साइट के लिए robots.txt file को generate करती है। पर मैं आपको यही सलाह दूंगा कि आप इस तरह की किसी भी वेबसाइट पर मत जाए।

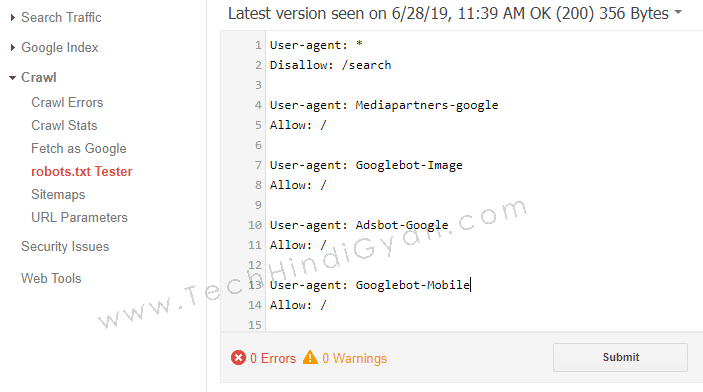

User-Agent

ये उस Robot का नाम हैं, जिसके लिए आप Command लिख रहें हैं। जैसे :- Google Bot, Google Bot-Image, AdsBot Google, Google Bot-Mobile, Mediapartners-Google, Etc. आप जिस रोबोट के लिए कोड लिख रहे हैं, User-Agent में उसका नाम लिखेंगे।

User-Agent : Mediapartner-Google

Mediapartner-Google, एक Google AdSense Robot हैं। User-Agent के अन्दर इस command को हम तब लिखते हैं, जब हम अपने साईट पर AdSense यूज़ कर रहे होते हैं। अगर आप अपने ब्लॉग या वेबसाइट में AdSense Code का इस्तेमाल करते हैं, तो आप Mediapartner-Google अपने Robots.txt में लिख सकते हैं।

User-Agent : *

User-Agent के अन्दर हम * चिन्ह का उपयोग तब करते हैं, जब हमें सभी Search Engine Robots को Same Instruction देना होता हैं। मतलब ये कि आप सभी सर्च इंजन को एक ही Command दे रहे हैं।

Disallow

Disallow Command के जरिये हम अपने साईट से जो चाहे वो, Search Engine Robot को Access करने से रोक सकते हैं। जो डाटा हम Search Engine में Index नहीं कराना चाहते हैं, उसे हम Disallow के अन्दर लिख सकते हैं। इसमें हम अपने ब्लॉग के Unwanted Pages, Unwanted Post, Categories, Labels, Tags, Etc. के Links लिख सकते हैं।

Allow

हम अपने साईट के जिस डाटा को सर्च इंजन में Index कराना चाहते हैं, उसे हम Allow के अन्दर लिखते हैं। सर्च इंजन आपके साईट के कौन कौन से डाटा को access कर सकता हैं, वो आप यहाँ से Allow कर सकते हैं। यह Search Engine Bots को आपके Content को Crawl और Index करने की अनुमति देता हैं।

Sitemap

यहाँ से आप Search Engine को अपने साईट के Sitemap की Path बता सकते हैं। जिससे सर्च इंजन को आपके content को rank और Index करने में आसानी हो। Sitemap के बारे में तो आप जानते ही होंगे। हमारे साईट के सभी डाटा का लिन्क यहाँ पर होता हैं। अगर आप Sitemap क्या हैं? Sitemap कैसे बनाये? जानना चाहते हैं। तो आप उस आर्टिकल को पढ़ सकते हैं।

Read More

Robots.txt हमारे Sites के लिए क्यों Important हैं?

Robots.txt file वेबसाइट पर मौजूद रहने से सर्च इंजन को वेबसाइट की sitemap को access करने में मदद मिलती है। इससे सर्च इंजन के bots को आसानी से पता चल जाता है कि वेबसाइट में क्या क्या rank करना है, और क्या क्या नहीं। सर्च इंजन bots जब किसी वेबसाइट या ब्लॉग पर आते हैं, तो वह robots.txt file में दिए गए instruction के अनुसार वेबसाइट के कंटेंट को crawl करते हैं।

वहीं, अगर सर्च इंजन bots को वेबसाइट में robots.txt file नहीं मिलेगी तो सर्च इंजन bots confuse हो जाएगा कि उसे वेबसाइट के किस-किस कंटेंट को crawl करना है। इस स्थिति में सर्च इंजन bots वेबसाइट या ब्लॉग के सभी कंटेंट को crawl करना शुरू कर देता है।

Robots.txt File कैसे Check करें?

अब सवाल उठता हैं कि Robots.txt File वेबसाइट में हैं या नहीं कैसे चेक करें? तो ये बहुत ही आसान हैं। आप आसानी से Robots.txt file को अपने वेबसाइट पर चेक कर सकते हैं।

इसके अलावा Google Search Console में जाकर भी आप Robots.txt Check कर सकते हैं, कि आपके साईट पर है या नहीं। उसके लिए आपको Google Search Console पर लॉग इन करना होगा। उसके बाद Crawl >> Robots.txt Tester पर क्लिक करेंगे।

Robots.txt File Blog में कैसे Add करें?

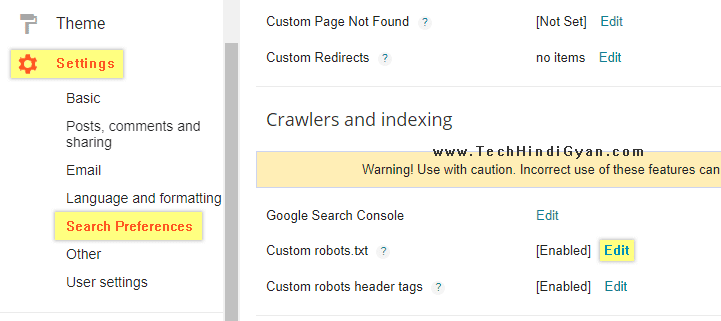

1) सबसे पहले Blogger.com पर जाए।

2) अब Settings पर जाए।

3) उसके बाद Search Preferences पर जाए।

4) अब Custom Robots.txt के Edit पर क्लिक करें।

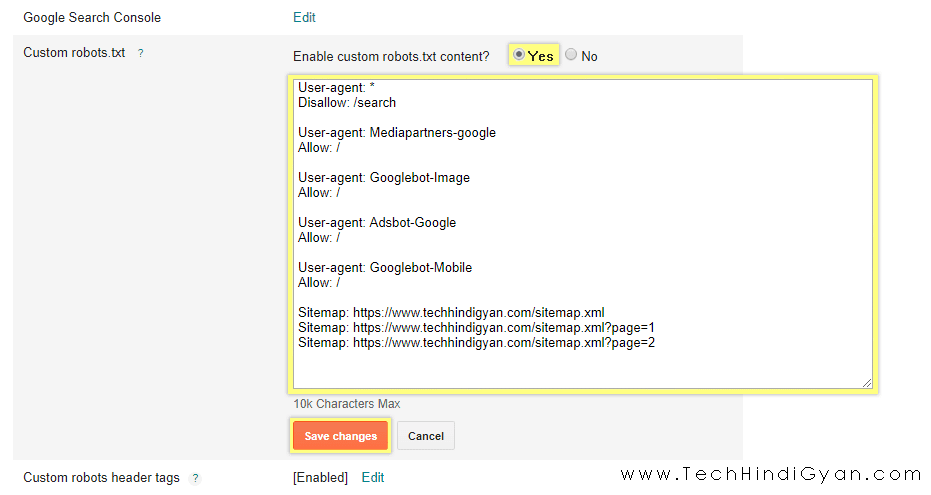

5) Edit पर क्लिक करने के बाद “Yes” पर Tick करना हैं।

6) Yes पर tick करते ही, एक Text Editor Box आपके सामने दिखेगा। जिसमे आपको ऊपर दिए गए कोड को कॉपी करके यहाँ पेस्ट करना हैं।

7) Sitemap पर आपको अपने ब्लॉग के Sitemap का Link लिखना हैं।

8) उसके बाद Save Changes पर क्लिक करके इस settings को save कर लेना हैं।

तो इस तरह से आप अपने ब्लॉग में Robots.txt File ऐड कर सकते हैं। आप अपने साईट के अनुसार robots.txt Code में बदलाव भी कर सकते हैं। जैसे :- अगर आप AdSense यूज़ नहीं करते तो code में Mediapartner-Google मत लिखें।